Comment indexer des pages dans Google ?

L'indexation sur Google est le processus par lequel le moteur de recherche répertorie et classe vos contenus pour les afficher dans ses résultats. Chaque jour, les robots d'exploration de Google crawlent des milliards de pages web pour maintenir son index à jour. Découvrez les étapes essentielles pour optimiser l'indexation de vos contenus et améliorer votre référencement naturel.

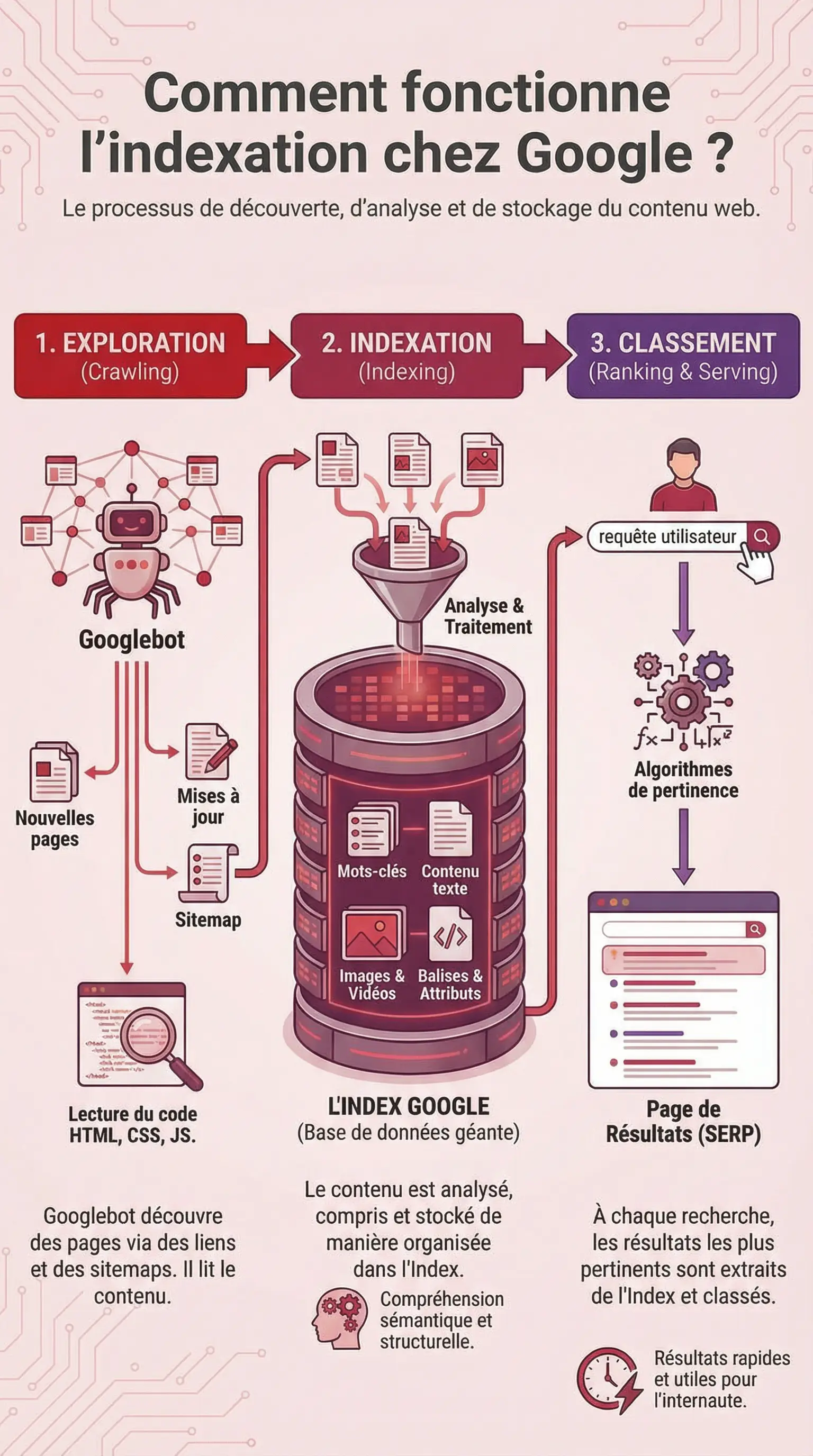

Comment fonctionne l'indexation chez Google ? (exploration, index, classement)

Pour afficher votre contenu dans ses résultats, Google suit un processus en trois étapes :

- Exploration : les Googlebots parcourent le web et découvrent les pages à traiter.

- Indexation : Google analyse et stocke le contenu dans sa base de données.

- Classement : les pages sont évaluées et positionnées selon leur pertinence.

Google attribue à chaque site un budget crawl (ou budget d'exploration) : un quota de pages qu'il accepte d'explorer à chaque passage de son robot Googlebot. Ce quota dépend de la taille de votre site (nombre de pages) et de critères techniques comme la vitesse de chargement, la profondeur de navigation ou la fréquence des mises à jour.

Conséquence ? Sans exploration suffisante, vos pages ne peuvent être indexées... et donc impossible d'apparaître dans les résultats de recherche.

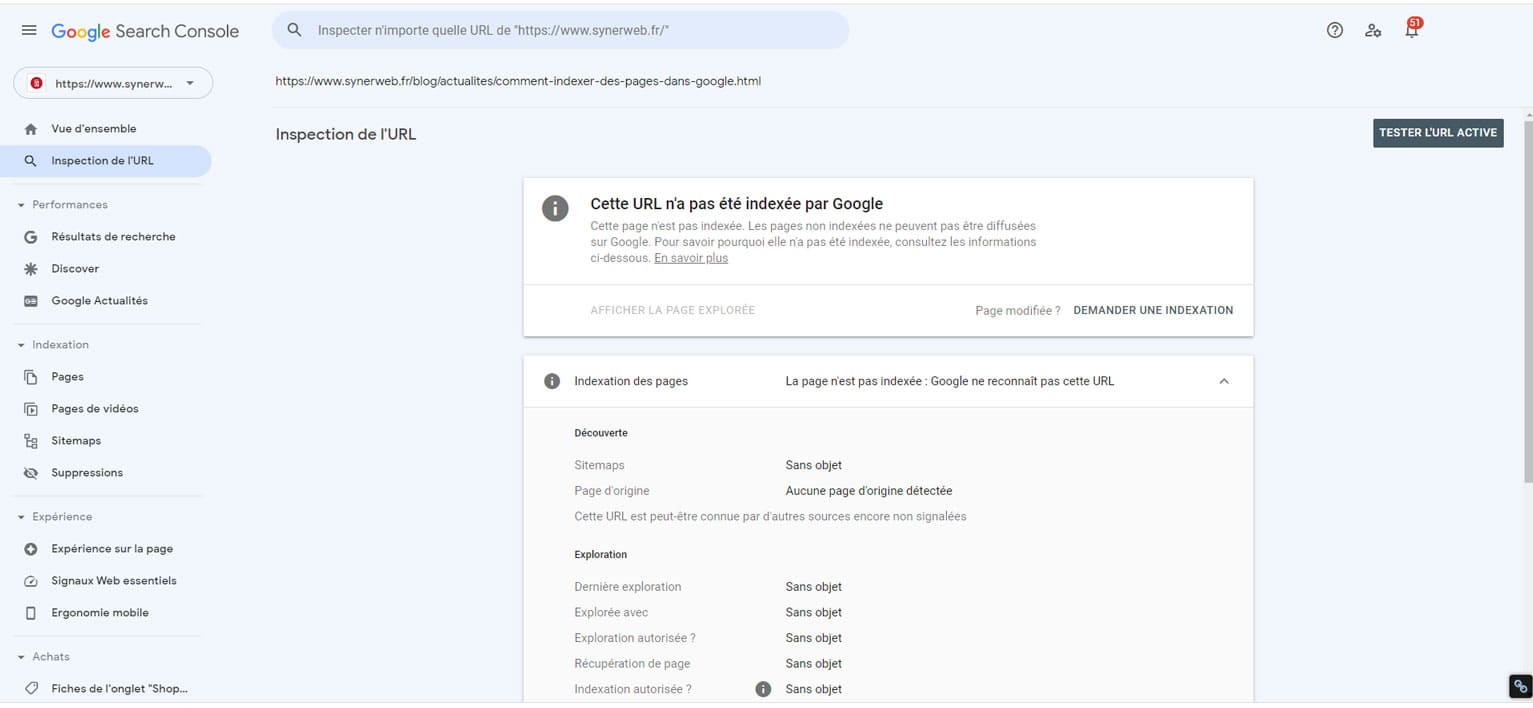

Google Search Console : demander et vérifier l'indexation

La Google Search Console est un outil gratuit permettant de vérifier l'indexation de vos pages, suivre leur performance et résoudre les erreurs techniques.

Pour demander l'indexation d'une page :

- Accédez à l'onglet « Inspection de l'URL ».

- Saisissez l'URL à vérifier.

- Cliquez sur « Demander une indexation » si nécessaire.

Vérifiez les balises Noindex

L'inspection révèle si une balise « noindex » ou « X-Robots-Tag » bloque l'indexation. Vérifiez les en-têtes HTML pour vous assurer qu'aucune directive ne bloque vos pages stratégiques.

Vérifiez la présence de balises canoniques (rel="canonical")

L'outil d'inspection de la Search Console vous informera si la page contient une balise canonique. Cette balise indique à Google quelle est l'URL principale (la "vraie" version) quand plusieurs adresses mènent au même contenu ou à du contenu similaire.

Si elle pointe vers une autre URL plutôt que vers la page elle-même, Google considérera cette autre URL comme prioritaire : il l'indexera et l'affichera dans les résultats de recherche, tandis que l'URL analysée sera ignorée ou dépriorisée.

Résultat : votre page risque de ne pas apparaître du tout, même si elle est de qualité.

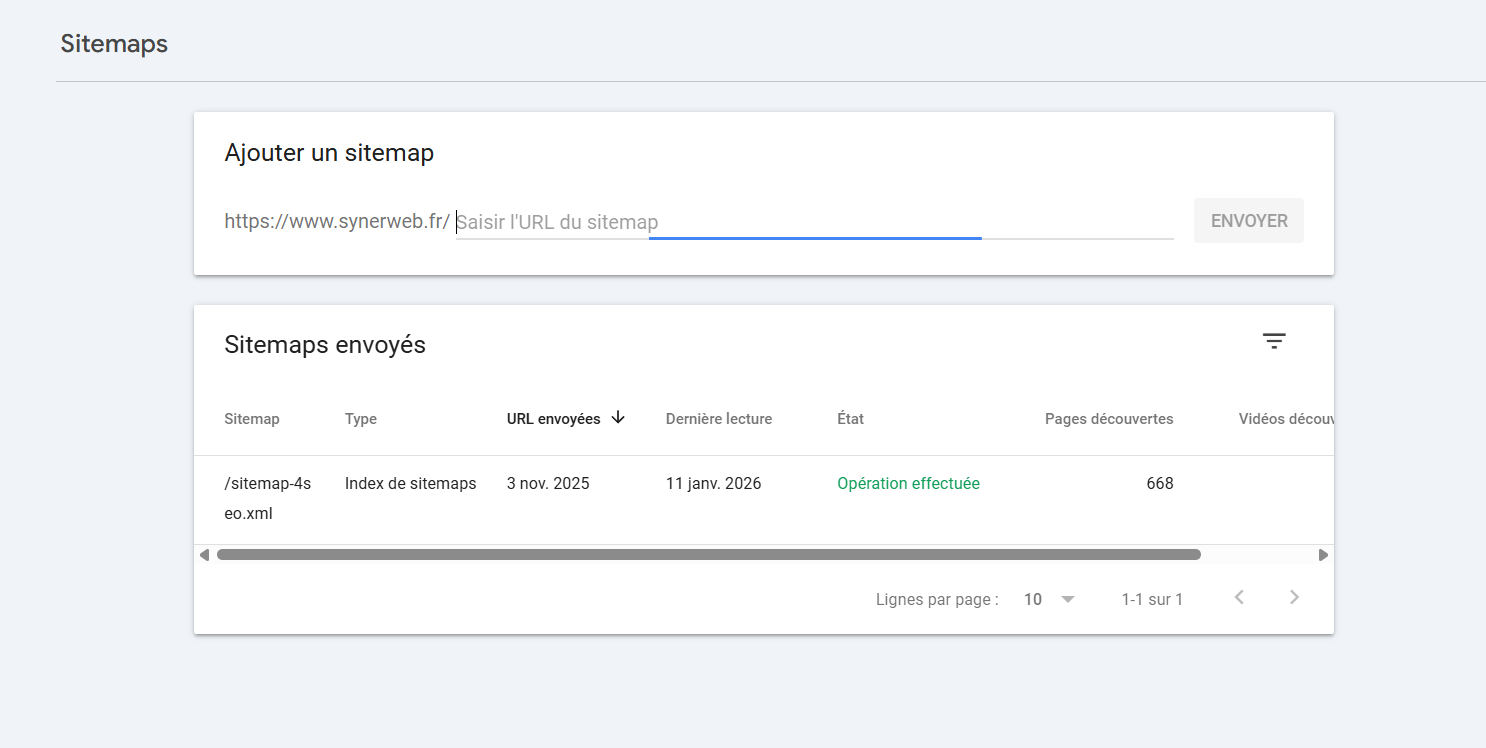

Communiquez un fichier sitemap.xml

Le sitemap.xml informe les robots sur vos URLs, dates de mise à jour et priorités. Soumettez-le via l'onglet « Sitemaps » de la Search Console.

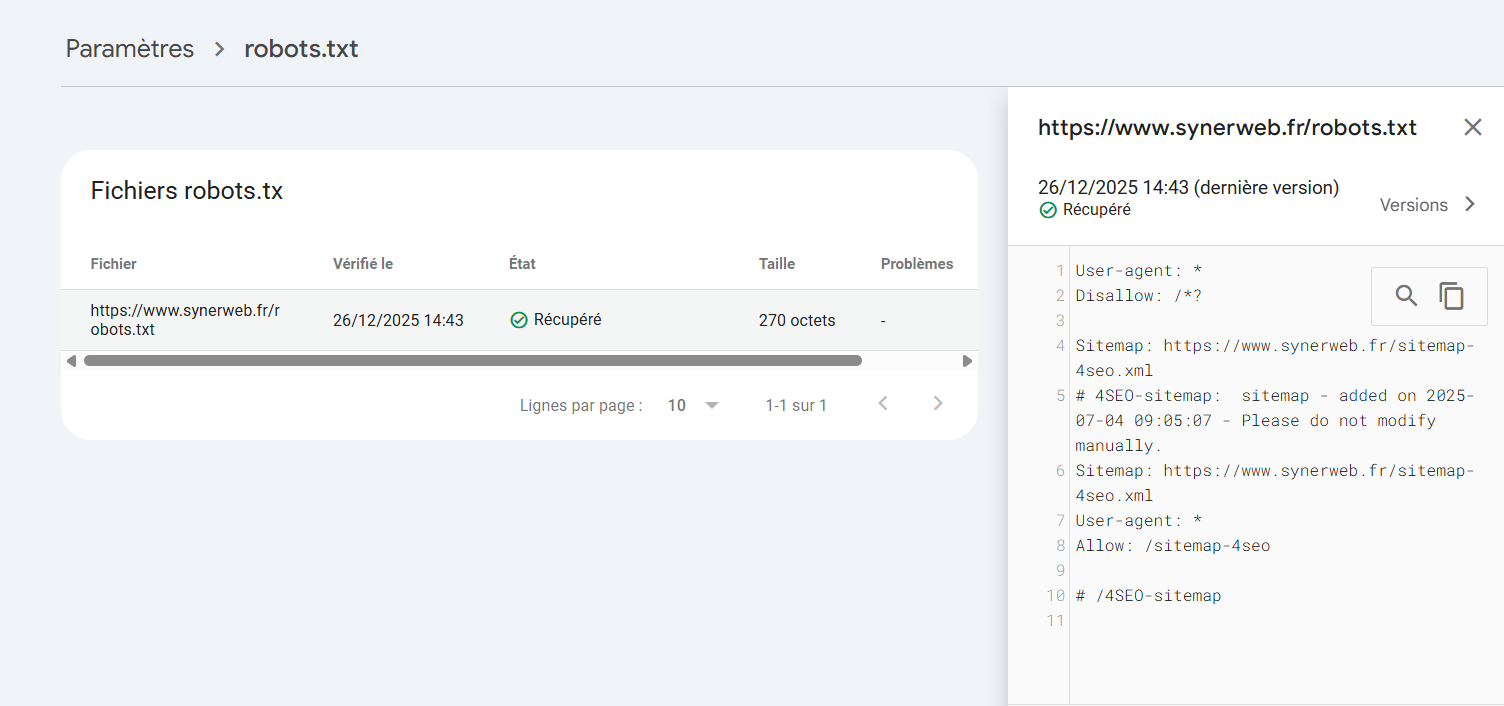

Fichier robots.txt : optimiser pour l'indexation Google

Le fichier robots.txt transmet des directives aux robots Google, indiquant quelles URLs ils peuvent explorer.

Vérifiez que vos instructions n'empêchent pas l'accès aux liens internes importants. Autorisez explicitement les ressources critiques et contrôlez régulièrement vos directives via la Search Console.

Maillage interne : accélérer l'exploration et l'indexation

Les Googlebots (les crawlers de Google) suivent les liens internes pour découvrir vos pages. Un maillage efficace réduit la profondeur de clic (idéalement moins de 3 clics depuis l'accueil) et optimise votre budget crawl. En dirigeant les robots vers vos pages stratégiques, vous favorisez leur indexation prioritaire.

Plan de site HTML

Le plan de site HTML, accessible en pied de page, offre une navigation claire aux utilisateurs et robots, facilitant l'indexation complète des sites volumineux.

Obtenez des backlinks

Pour accélérer l'indexation, obtenez des backlinks de qualité et partagez vos contenus sur les réseaux sociaux. Ces signaux indiquent à Google l'autorité et la pertinence de votre site.

L'indexation des pages par Google est un processus essentiel pour gagner en visibilité dans les résultats de recherche. N'hésitez pas à vérifier les différents points énumérés ou à contacter une agence de référencement SEO comme SYNERWEB pour optimiser l'indexation de votre site internet.

FAQ sur l'indexation Google

Qu'est-ce que l'indexation sur Google ?

L'indexation est le processus par lequel Googlebot analyse et stocke vos pages dans l'index Google pour les rendre accessibles aux internautes.

Comment demander l'indexation de mon site sur Google ?

Utilisez l'outil d'inspection d'URL dans la Search Console pour soumettre vos pages. Le temps d'indexation Google varie généralement de quelques jours à plusieurs semaines.

Comment indexer un site sur Google ?

Soumettez un fichier sitemap.xml via la Search Console et optimisez votre maillage interne pour faciliter l'exploration de l'index Google.

Comment référencer son site sur Google ?

Créez du contenu de qualité, vérifiez l'absence de balises noindex et optimisez votre structure technique pour améliorer votre positionnement dans l'index Google.

Pour en savoir plus, découvrez notre article "Comment référencer son site web sur Google et jusqu'où peut-on aller sans une agence SEO ?"